엣지 센서에서 CPU 가속기까지 ‘버설 AI 엣지 시리즈’

발표/레한 타히르(Rehan Tahir), 자일링스 버설 AI 엣지 시리즈 수석 제품라인 매니저

정리/배인순, 프리랜서

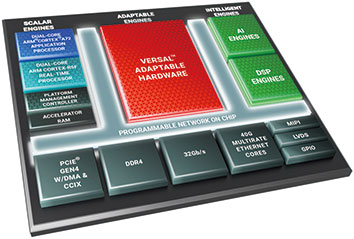

버설 AI 엣지 시리즈는 이미 생산 검증이 완료된 7nm 버설 아키텍처를 기반으로 짧은 지연시간의 AI 컴퓨팅을 수행할 수 있도록 소형화되었으며, 6W 미만의 전력 효율과 엣지 애플리케이션에서 필요로 하는 안전 및 보안 요건을 모두 제공한다. 또한 다양한 프로세서를 내장한 이기종 플랫폼인 버설 AI 엣지 시리즈는 임베디드 컴퓨팅을 위한 스칼라 엔진(Scalar Engine)과 센서 융합 및 하드웨어 적응성을 위한 적응형 엔진(Adaptable Engine), 그리고 엣지 애플리케이션을 타깃하는 ASSP 및 GPU와 비교할 수 없는 최대 479(INT4)TOPS1까지 확장이 가능한 AI 추론과 비전, 레이더, 라이다(LiDAR) 및 SDR(Software Defined Radio) 등의 첨단 신호 프로세싱 작업부하를 위한 지능형 엔진(Intelligent Engine)을 사용하여 알고리즘에 따라 엔진을 최적화할 수 있다.

본 고에서는 자동차 및 로보틱스, 헬스케어, 항공우주 애플리케이션을 위한 지능형 AI를 제공하는 새로운 버설 AI 엣지 ACAP 시리즈에 대해 자일링스 버설 AI 엣지 시리즈 수석 제품라인 매니저인 레한 타히르(Rehan Tahir)의 발표를 토대로 정리한다.

레한 타히르는 “엣지에는 여러 속성이 있다. 이런 속성들이 결합되면서 엣지 분야의 성장이 빠르게 진행되고 있다. 바로 짧은 지연시간, AI 컴퓨팅, 저전력, 그리고 안전 및 보안이다. 저희 데이터센터 및 네트워크 분야에서는 이미 AI 컴퓨팅, 저전력, 그리고 안전 및 보안은 확보가 되어있다. 그런데 버설 AI 엣지는 ‘짧은 지연시간’과 엣지 부분에서의 자율성을 향상시킬 수 있다. 또한 실시간 시스템(Real-time systems)이 가능하다”고 설명했다.

그는 또 “2018년도에 이미 버설 ACAP을 발표한 바 있다. ACAP(Adap-tive Compute Acceleration Platform)은 적응형 컴퓨팅 가속화 플랫폼을 의미한다. 그래서 저희가 AI 코어(Versal™ AI Core), 프라임(Versal™ Prime) 발표를 했고, 작년에는 프리미엄(Versal™ Premium)까지 발표를 했다. 하지만 이들은 클라우드 및 네트워크에 집중됐다고 말씀드릴 수 있다. 이제는 기존에 이종(Heterogeneous)의 엔진을 지원하던 ACAP 아키텍처를 가져와서 초소형화 함으로써 ACAP 기술의 향상된 와트 당 성능을 엣지에 제공하게 되었다”고 덧붙였다.

그림 3에는 실시간 시스템에서 소형화가 필요한 분야들이 화면에 나와 있다. 여기에 AI 컴퓨팅이 제공될 예정인데, 엣지 단에서는 열 및 전력부문에서의 제약들이 있다. 이러한 부분에서의 극복이 필요하다. 각 분야들에 대해 좀 더 자세하게 설명 드리겠다.

그림 3에 나와있는 애플리케이션, 그리고 이외의 애플리케이션들의 공통점은 바로 AI가 점점 더 중추적인 요소가 되어간다는 점이다. 그리고 이들 시스템은 실시간 시스템이기 때문에 지연이 허용될 수 없는 초저지연이 필요하다. 스마트 비전, 드론, 무인 항공기(UAV), 협동 로봇, 그리고 특히 ADAS 및 자율주행에 많이 적용되었다. 또한 의료 영상분야에서는 내시경검사, 초음파, 그리고 의료 로봇 등의 실시간 시스템에 저지연이 필요하다.

레한 타히르는 “다시 버설 이야기로 되돌아가보겠다. 저희가 AI 코어, 프라임, 프리미엄 부분에 대해서는 이미 언급을 했다. AI 코어와 프라임은 7 나노미터(nm) 아키텍처를 기반으로 이미 론칭이 되었다. 그런데 이것과 동일 아키텍처를 갖고 소형화를 하기 때문에 저희는 AI 엣지 생산 부분에 있어서 큰 확신을 가지고 있다. 이런 부분이 바로 자일링스가 가진 강점이자 독특한 점이다. 버설 AI 엣지도 마찬가지이다. 저희가 다른 디바이스들을 생산하며 들인 노력들이 이미 결집되어 있기 때문에, 물론 엣지 분야에는 다른 경쟁사나 디바이스들이 있을 수 있겠지만 사실 생산이 그리 쉬운 일만은 아니다. 그렇기 때문에 저희 자일링스에는 그만큼 신뢰를 가지실 수 있다. 또한 버설 시리즈의 6가지 포트폴리오들은 TSMC의 7 나노미터(nm) 핀펫 프로세스(FinFET process) 기술을 이용해서 생산되고 있다”고 말했다.

레한 타히르는 “발표의 핵심부분이다. 저희 버설 AI 엣지가 어떻게 지능형 기능을 가속화하고 있는지에 대해 3가지 요소를 설명하겠다. 첫번째로 GPU 대비 4배의 와트 당 AI 성능을 갖추었다. 두번째로는 이전 세대와 비교 시 컴퓨팅 밀도 측면에서 10배의 기능 개선이 이뤄졌다. 세번째로는 세계에서 가장 확장성이 뛰어난 적응형 플랫폼이다”라고 정의하였다.

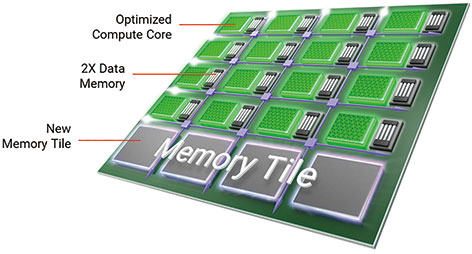

그림 5는 성능 개선이 어떻게 달성됐는 지에 대해 보여주고 있다. AI 엔진의 머신러닝을 위해 최적화된 버전이 있다. 이것을 AI엔진-ML 또는 AIE-ML(AI Engine-Machine Learning)이라고 부른다. 이것은 엣지 시리즈에서 적용될 것이며, 또한 AI 코어 시리즈에서 이미 적용이 되었던 부분이다.

그림 우측의 AI엔진-ML 어레이(Array)를 보시면, 여러 최적화 작업이 이뤄졌다. 첫째는 바로 컴퓨트 코어(Compute Core)의 각 타일(Tile) 부분에서 컴퓨팅 역량의 최적화가 되었다. 또한 INT4 및 BFLOAT16 데이터 타입에 대해 네이티브 지원이 되고 있다.

컴퓨트 코어 다음에는 메모리가 있다. 데이터 메모리도 2배 증가했다. 맨 하단에는 새로운 메모리 타일(Memory Tile)이 추가됐다. 이로 인해 AI엔진 어레이 전반에 걸쳐 더 높은 대역폭의 메모리 액세스가 지원됐다. 또한 메모리 병목 현상이 제거됐다.

요약 드리자면 저희는 기존 AI 아키텍처와 대비 시 머신러닝 추론 부분에서 4배의 성능 향상을 시킬 수 있었다. 2배의 멀티플라이어, 2배의 INT8 성능, INT4에 대한 네이티브 지원, 그리고 2배의 데이터 메모리 덕분이다. 아울러 지연시간을 절반으로 줄일 수 있었던 이유는 로컬 메모리를 향상시키면서 동시에 하단에 메모리 타일이 추가됐기 때문이다.

그림 6을 보면 머신러닝 추론 애플리케이션 엣지에는 4배의 성능 개선이 되고 지연시간은 절반으로 감소했다. 버설 AI 엣지 시리즈에는 2가지 기술이 사용되었다. 첨단 신호 프로세싱에는 AI 엔진 아키텍처, 그리고 머신러닝에는 AI 엔진-ML 아키텍처이다. 버설 AI 엣지 시리즈에는 대부분 AI 엔진-ML이 적용되었다. 그 이유는 AI 엔진-ML에는 엣지 단에서 주로 처리해야 되는 작업인 워크로드를 위해 최적화 되어있기 때문이다. CNN, RNN, MLP 등이 지원되었다.

반면에 첨단 신호 프로세싱에는 AI 엔진 아키텍처가 사용되고 있다. 이 경우는 빔포밍, 레이더 프로세싱, 고성능 컴퓨팅에 특화되어 있다. 그렇기 때문에 디바이스 구매를 고려할 때 자신에게 필요한 부분에 따라 선택할 수 있다.

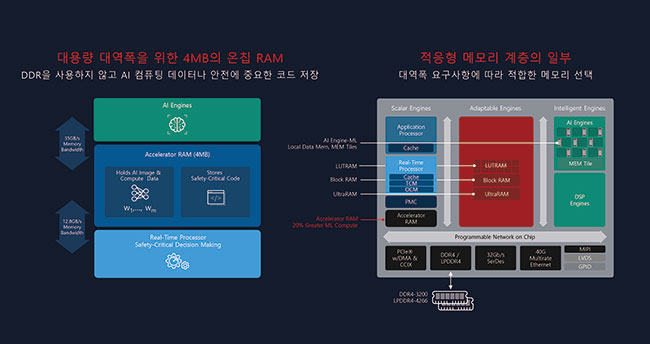

그림 7을 통해 아키텍처의 또다른 혁신에 대해 살펴보겠다. 바로 가속기 RAM이 적용되었다는 점이다. 저희는 초소형 디바이스까지 4MB 온칩 RAM을 제공하고 있다. 그런데 4MB가 그렇게 크지 않다고 생각하실 수도 있겠지만, 저희 포트폴리오를 보시면 이런 가속기 RAM을 통해 추가 리소스가 제공되어 성능이 개선됐다는 점을 느끼실 수 있을 것이다.

가속기 RAM을 이용하여 오프칩(Off-Chip) DDR이 아닌, 디바이스단에서 메모리를 갖췄기 때문에 데이터를 곳곳에서 유지하는 식으로 성능 개선이 되었다. 예를 들어 머신러닝 추론에서 중요한 가중치(Weight) 등이 가속기 RAM에서 처리가 될 수 있고, AI 컴퓨팅 데이터나 안전에 중요한 핵심 코드들이 온칩(On-Chip) 상에서 저장될 수 있다.

이제 우측에 나온 버설 AI 엣지의 디바이스 그림을 보겠다. 좌측 하단에 가속기 RAM이 있는데, 실시간 프로세서와 잘 결합되어 있다. 이처럼 실시간 시스템이 필요로 하는 곳에 위치했기 때문에 기능 안정성이 확보 가능하다.

가속기 RAM은 적응형 메모리 계층에 더 추가되어 있다. 지능형 엔진(Intelligent Engine)의 MEM 타일에 추가되었고, 적응형 엔진(Adaptable Engine)에는 LUTRAM, Block RAM 및 UltraRAM이 있다. 스칼라 엔진(Scalar Engine)에는 가속기 RAM이 있으며, 외부 DDR4 / LPDDR4도 같이 연결될 수 있다.

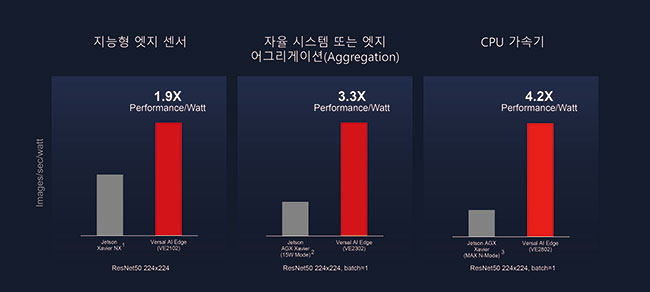

그림 8을 보면 AI 엔진-ML 및 가속기 RAM의 혁신을 통해서 GPU대비 4.2배의 와트 당 성능 개선이 달성되었음을 확인할 수 있다. 저희 버설 AI 엣지 포트폴리오를 엔비디아(Nvidia)의 젯슨 AGX 자비에(Jetson AGX Xavier) 시리즈와 비교한 3개의 그래프를 보자. NX, AGX(15W 모드), AGX(MAX N-모드)와 비교했다. 자일링스는 각 시리즈 별 최고사양을 비교했다. 맨 우측의 그래프는 VE2802 버설 AI 엣지 제품과 젯슨 AGX 자비에의 MAX N-모드를 비교한 모습이다. Y축은 파워 당 처리량 또는 와트 당 이미지 처리를 뜻하다. 참고한 엔비디아의 데이터는 그들의 웹사이트의 보드 전력에 대해 나온 내용을 기반으로 디바이스 전력을 산출한 것이다. 자일링스 내용은 이미 생산되고 있는 AI 코어 디바이스를 기반으로 한 실시간 데이터를 통해 시뮬레이션 한 것이다. AI 엔진-ML 덕분에 GPU 기술과 대비하여 높은 수준의 성능 개선을 이룩할 수 있었다. 미드레인지 제품(도표 상 VE2302)의 경우 3.3배, 그리고 지능형 엣지 센서(도표 상 VE2102)는 1.9배의 성능 개선이 이뤄졌다.

이 그래프와 관련하여 많이 받게 되는 질문이, ‘버설 AI 엣지가 엔비디아의 젯슨 AGX 자비에 시리즈와 비교했을 때 성능 개선되었다는 점은 이해가 되는 데, 그렇다면 엔비디아의 차세대 제품인 오린(Orin)과 비교했을 땐 어떻게 되는가?’이다. 그런데 오린 관련해서는 아직 TOPS(Tera Operations Per Second) 숫자 외에는 어떠한 데이터도 제공되고 있지 않기 때문에 사실상 저희가 비교하기가 쉽지 않다. 그들이 공개한 숫자는 254 TOPS 정도이고, 이것이 어디서 나오는 지에 대해서 명확한 설명이 없기 때문에 추후 저희가 좀 더 많은 정보를 얻게 된다면 비교를 해드릴 수 있을 것 같다.

이제 보안 문제를 살펴 보자. 자일링스가 버설 AI 엣지를 통해 10배의 컴퓨팅 밀도와 최고 레벨의 안전 및 보안 기능을 제공하는 내용을 설명하겠다.

그림 9의 비교를 하기 위해서 특정 사용 사례에 대해 살펴보겠다. 현재 자동차 업계는 자율주행 레벨 3을 향해 가까이 가고 있다. 그래서 레벨 3의 반자율주행(Level 3 Semi-Automated Driving)에 있어서 2가지 서로 다른 시스템을 적용 시 어떻게 비교가 되는 지 설명한다. 왼쪽 그림은 이미 생산되어 있는 디바이스들을 사용하는 것이고, 오른쪽 그림은 버설 AI 엣지 1개를 사용하는 것이다. 기존에는 3개의 징크(Zynq) 디바이스가 고성능 전방 카메라, 4대의 서라운드 뷰 카메라, 전해상도의 운전자 모니터링 시스템 등을 수행하기 위해 필요했다. 하지만 새로운 버설 AI 엣지는 단 1개만 사용하더라도 기존 기능들에 덧붙여서 라이다(LiDAR), 디스플레이, 초음파 센서(Ultrasonic Sensor)까지 추가 연결이 가능하다. 이 경우에 3개의 디바이스를 1개로 통합했기 때문에 보드 공간이 60% 개선되었다.

또한 컴퓨팅 측면에서도 4.4배 개선되었다. 이는 AI 엔진-ML 덕분이기도 하지만, 추가적으로 센서 퓨전(Sensor Fusion), 이미지 프로세싱이 가능하기 때문에 그렇다. 이런 모든 요소들이 결합되어 (버설 AI 엣지 1개를 사용할 경우) 10배의 컴퓨팅 밀도가 형성되면서 동시에 전력 측면에서는 거의 같은 수준으로 소모되었다.

그림 10에 나와 있는 버설 AI 엣지 시리즈는 모두 자동차 품질 등급 및 인증이 획득된 것이다. 자일링스의 자동차 등급(Automotive Grade)은 Q-grade (영하 40ºC에서 영상 125ºC)까지 지원 가능하다. 저희 제품이 자동차 시스템에도 적합하기 때문에 차량용 기능 안전(Functional Safety)에 해당하는 ISO 26262가 지원되었다.

그림 11을 보면서 소프트웨어 분야를 설명하겠다. ACAP 플랫폼을 위한 툴이다. 아까 자동차 이야기를 드렸었는데, 소프트웨어 스택(라이브러리, 프레임워크 및 에코시스템)을 제공함으로써 모든 개발자들이 빠르게 구축하고 개발할 수 있도록 돕고 있다.

자동차 애플리케이션에서 주로 쓰이는 딥러닝 프레임워크인 카페(Caffe), 텐서플로우(TensorFlow), 파이토치(PyTorch)도 지원되고 있다. 이러한 프레임워크들은 UAV에서도 사용되고 있다.

다음으로 로보틱스 애플리케이션에는 ROS, ROS2, 그리고 최근에 추진력을 얻고 있는 오픈소스 3D 로봇 시뮬레이터인 가제보(GAZEBO)도 지원하다. 이 툴 플로우를 보시게 되면, 자일링스 런타임(XRT: Xilinx Runtime)이 있어서 프레임워크와 라이브러리를 연결한다. 라이브러리는 바이티스(Vitis)를 통해 60개 이상, 바이티스 AI(Vitis AI)에서 70개 이상이 깃허브(GitHub)에서 제공되었다.

그림 12를 보면서 적응성 관련하여 도메인 특화 아키텍처(DSA), 그 다음에는 추가적인 유연성을 제공하는 동적 기능 교환(DFX)까지 말씀드리겠다.

도메인 특화 아키텍처라는 용어는 자일링스에서 만든 용어가 아니고 업계 용어이다. 이 DSA 측면에서 ASSP, GPU 대비해서 특별히 차별화를 제공할 수 있는 부분이 있다. 바로 적응형 엔진들을 파티션 구분하여 이 알고리즘을 필요에 따라 업데이트 한다. 따라서 해당 디바이스가 미래 지향적인 설계가 되도록 할 수 있으며, 가장 최신의 업데이트가 가능하도록 한다.

좋은 예를 들어보겠다. ‘안전과 보안, 전용 로직이 있고, 다른 편에는 라이다 이미지 처리 알고리즘이 있다’라고 가정하자. 사실 라이다 분야에는 굉장히 많은 혁신이 계속 나오고 있다. 그래서 12개월 후에 새로운 라이다가 구현되었다라고 가정해보면, 이 부분을 적용하기 위한 과정에서 하드웨어/소프트웨어가 모두 재구성(Reconfigurable) 가능하다라는 점이다. HW/SW 둘 다 가능한 이유는 실리콘 업데이트가 OTA(Over-The-Air) 상에서 이뤄지기 때문이다.

동적 기능 교환의 경우에는, 하나의 로직을 다양한 용도로 분할(Partitioning)하여 더 큰 디바이스 또는 여러 디바이스를 사용할 필요가 없다. 또한 재사용이 가능하여 전력 및 비용이 절감되었다.

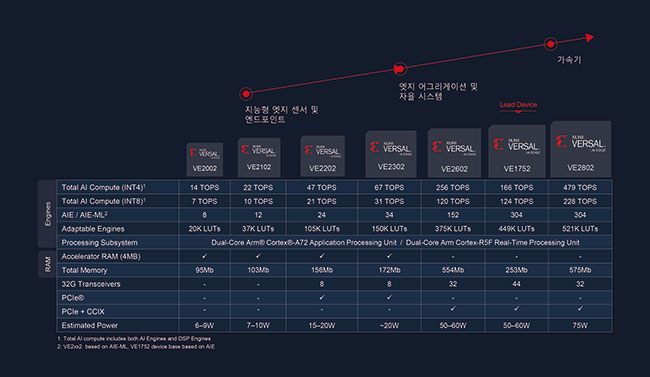

그림 13은 확장 가능성을 나타내는 그림이다. 7가지 버설 AI 엣지 디바이스가 나열됐다. 가장 좌측에는 지능형 엣지 센서가 있고, 미드레인지에는 센서 퓨전, 엣지 어그리게이션 및 자율 시스템, 우측은 강력한 가속기에 최적화된 퍼포먼스를 제공할 수 있는 고사양 부분이다.

리드 디바이스(Lead Device)라고 나와있는 VE1752는 AI 엔진 기반 아키텍처이다. 그 이외의 제품명들은 VE다음에 숫자 2로 시작한다. 이들은 AI 엔진-ML 아키텍처를 사용하고 있다.

전체적으로 보시면 굉장히 넓은 범위의 포트폴리오가 구축되었다. 가장 좌측에는 약 10 정도의 TOPS, 그리고 가장 우측은 약 480정도의 TOPS가 제공되고 있다. 좌측 4개의 디바이스를 보시면(VE2002, VE2102, VE2202, VE2302) 가속기 RAM(4MB)이 있다. 전체 메모리(Total Memory)가 200Mb 이하인 제품에는 이렇게 4MB의 가속기 RAM이 별도로 제공되었다. 이점은 머신러닝의 워크로드를 위한 메모리 계층화 측면에서의 장점을 나타낸다.

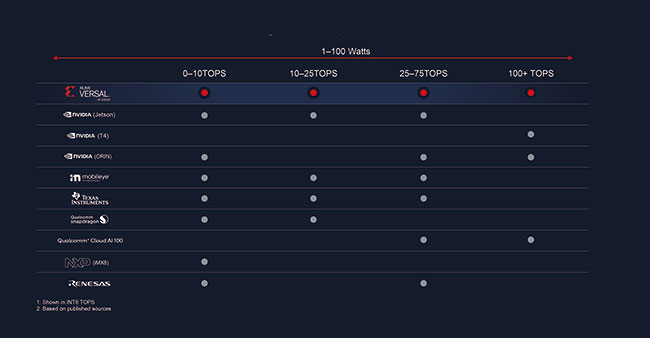

그림 14에서 보인 바와 같이 다른 업계의 디바이스와 비교 시, 자일링스는 확장성 덕분에 동일한 포트폴리오 내에서 로우엔드(Low-End), 미드레인지(Midrange), 하이엔드(High-End)의 퍼포먼스를 필요로 하는 레벨들이 지원 가능하다. 이것이 중요한 이유는 각 영역별로 계속해서 연평균 성장률(CAGR)이 두 자릿수로 계속 증가한다는 점이다. 그렇기 때문에 로우엔드, 미드레인지, 하이엔드 모두 간과할 수 없는 부분이다.

확장성이 가장 중요해지는 이유는 하나의 프로세스 노드, 그리고 바이티스, 바이티스 AI 등의 한 가지 소프트웨어 스택, 라이브러리가 있기 때문에 디자인을 한번 한 뒤에 필요에 따라 위 또는 아래로 갈 수 있다는 점 때문이다. 경쟁사들의 경우 로우엔드-미드레인지에 집중하거나 또는 아예 하이엔드만 공략하기도 한다. 그런데 저희는 퍼포먼스 전체 영역에 대해 모두 지원하고 있다.

다음은 버설 AI의 고객에 대한 지원 및 공급이다. 현재 설계 문서가 이용 가능하다. 6월 9일에 글로벌 론칭을 하면서 웹사이트(https://www.xilinx.com/versal-ai-edge)에 모든 관련 정보가 업로드 되어 있다. 또한 얼리 액세스 프로그램(Early Access Lounge)을 통해 버설 AI 엣지에 대한 추가 문서들이 고객사에 제공될 수 있다.

다음으로 2021년 하반기에 바이티스, 바이티스 AI 관련 툴 지원이 될 예정이다. 2022년 상반기에는 엔지니어링 샘플(ES: Engineering Sample)과 프로덕션 실리콘이 공급될 예정이다. 끝으로 2022년 하반기에는 버설 AI 엣지 ACAP 평가키트가 공급될 것이다.

아까 말씀드앞서 설명했던 리드 디바이스인 VE1752(AI 엔진 기반 아키텍처), 그리고 AI엔진-ML 제품들의 샘플들은 모두 2022년 상반기에 나올 예정이다.

평가키트가 2022년에 나올 것이라고 말씀드렸다. 그런데 버설 AI 엣지의 장점이 사실 버설 AI 코어의 소형화다 보니까 필요하시다면 ACAP VCK190 평가키트를 바로 구매하셔서 설계를 시작하시는 것도 가능하다(그림 16 참조).

VCK190은 이미 웹사이트(https://www.xilinx.com/products/boards-and-kits/vck190.html)에 해당 정보가 기재되어 있다. VCK190 평가키트를 이용하시면 버설 AI 엣지의 핵심 블록들에 대해 테스트가 가능하다. 또한 라이브러리, 툴, 인터페이스 등에 대해 미리 살펴볼 수 있다. VCK190을 사용하시는 고객들의 경우 추후 버설 AI 엣지로 넘어갈 경우 학습 곡선을 훨씬 더 단축시킬 수 있다.

버설 AI 엣지 시리즈는 기존의 CPU, GPU, FPGA를 훨씬 능가하는 성능과 유연성을 제공하는 완벽하게 소프트웨어로 프로그램이 가능한 적응형 SoC인 버설 ACAP 포트폴리오의 최신 제품이다. ACAP은 하드웨어 및 소프트웨어 레벨에서 모두 변경이 가능하기 때문에 엣지에서 클라우드까지 광범위한 애플리케이션과 작업부하의 요구사항에 따라 동적으로 적응이 가능하다. 버설 AI 코어(Versal AI Core)와 버설 프라임(Versal Prime) 시리즈는 현재 생산 중이며, 버설 프리미엄(Versal Premium) ACAP은 현재 샘플이 공급되고 있다.

알베오 U55C의 출시로 HPC 업계에 많은 가치 제공할 것

조회수 815회 / Nathan Chang

엣지 센서에서 CPU 가속기까지 ‘버설 AI 엣지 시리즈’

조회수 1022회 / Rehan Tahir

적응형 컴퓨팅, 포스트-무어의 법칙 시대에서 성장을 주도하다

조회수 1366회 / Victor Peng

데이터센터 혁신을 위한 장벽 없는 FPGA 솔루션

조회수 1005회 / Kartik Srinivasan 외 2인

자동차 시장의 혁신을 선도하는 자일링스의 DNA

조회수 741회 / Yousef Khalilollahi

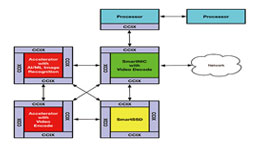

CXL, CCIX 기반 PCIe 5와 SmartNIC은 어떻게 가속 솔루션을 혁신하고 있...

조회수 6823회 / Scott Schweitzer

대규모 5G 무선 구축을 위한 혁신적인 징크 RFSoC DFE

조회수 1500회 / Gilles Garcia

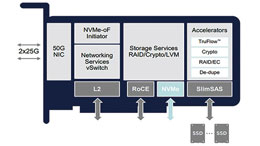

SmartNIC 아키텍처: 가속기로의 이행, 그리고 FPGA가 우위를 점하는 이유

조회수 4488회 / Scott Schweitzer

SmartNIC이 일반 NIC보다 뛰어난 이유는?

조회수 1876회 / Scott Schweitzer

PDF 다운로드

회원 정보 수정