적응형 컴퓨팅을 활용한 AI 모델의 상용화 문제 해결

글/닉 니(Nick Ni), 자일링스 AI 및 소프트웨어, 에코시스템 제품 마케팅 디렉터

린제이 브라운(Lindsey Brown), 자일링스 소프트웨어 및 AI 제품 마케팅 스페셜리스트

데이터가 폭발적으로 증가하고, 혁신은 가속화되고 있으며, 알고리즘도 빠르게 변화하고 있다. AI(Artificial Intelligence)는 거의 모든 산업에서 점점 보편화되고 있지만, 대부분의 AI 수익은 AI 모델의 정확성과 효율성을 개선하는 AI 트레이닝을 통해 발생하고 있다. 추론 산업은 이제 초기 단계이지만, 조만간 AI 모델의 ‘상용화’가 가속화되면서 트레이닝 수익을 능가하게 될 것이다.

AI 추론은 아직 초기 단계에 머무르고 있기 때문에 앞으로 개선의 여지가 매우 많다. 자동차 산업의 경우, 대부분의 차량은 아직 ADAS(Advanced Driver-Assistance System)가 지원되지 않고 있으며, 드론이나 물류 로봇 또한 초기 단계에 머무르고 있다. 또한 AI 기반 의료 수술용 보조 로봇도 아직은 완벽하지 않으며, 데이터 센터의 음성인식, 비디오 자동 묘사, 유해 이미지 감지 기능들도 많은 개선이 요구되고 있다.

수요 증가에 대응

AI 추론의 최신 AI 모델은 기존 알고리즘에 비해 훨씬 더 높은 컴퓨팅 성능을 요구하기 때문에 하드웨어에 대한 요구가 급증하고 있다. 그러나 점진적으로 진화하는 실리콘 성능에 계속 의존할 수는 없다. 프로세서 주파수는 이미 데나드 스케일링(Dennard Scaling)이 한계에 도달하면서 알고리즘은 더 이상 몇 년마다 ‘무료’ 속도 향상이라는 이득을 얻을 수 없게 되었다. 또한 암달의 법칙(Amdahl’s Law)에 따르면, 더 많은 프로세서 코어를 추가하는 것도 한계치에 달해 있다. 코드의 25%를 병렬화할 수 없다면, 코어 수에 관계없이 최대 속도는 4배에 머무르게 된다. 그렇다면 점점 증가하는 하드웨어 성능 요구에 어떻게 대처할 것인가? 바로 DSA(Domain Specific Architecture), 즉 도메인별 특화 아키텍처가 답이다.

각 AI 모델은 데이터 플로우가 점점 복잡해지고, 과중성도 가중되고 있으며, 오늘날의 CPU, GPU, ASSP 및 ASIC은 이러한 혁신 속도를 따라잡기 위해 고군분투하고 있다. 범용으로 사용되는 CPU는 어떠한 문제도 실행할 수는 있지만, 컴퓨팅 효율이 부족하다. 고정형 하드웨어 가속기는 혁신에서 상당히 안정화된 ‘상용’ 작업부하를 위해 설계되었다. DSA는 ‘각 작업부하 그룹’이 최고의 효율로 실행될 수 있도록 하드웨어에 대한 커스터마이징이 새롭게 요구되고 있다.

커스터마이징을 통한 고효율 달성

모든 AI 네트워크는 최고의 효율을 달성하기 위해 커스터마이징이 필요한 3가지 구성요소, 즉 커스텀 데이터 경로, 커스텀 정밀도, 커스텀 메모리 계층을 가지고 있다. 새롭게 등장하는 대부분의 AI 칩은 강력한 성능의 엔진을 갖추고 있지만, 이러한 3가지 구성요소의 비효율성 문제로 인해 데이터를 충분히 빠르게 처리하지 못한다. 그렇다면 AI 추론에서 DSA는 어떠한 의미를 갖는지 살펴보도록 하자. 모든 AI 모델은 약간 또는 때로는 상당히 다른 DSA 아키텍처가 필요하다. 첫 번째 구성요소는 커스텀 데이터 경로이다. 모든 모델은 브로드캐스트, 캐스케이드, 스킵스루(Skip Through) 등을 사용하여 레이어 간의 데이터를 전달하는데 필요한 서로 다른 토폴로지를 가지고 있다. 데이터가 항시적으로 제공되어 다음 레이어의 프로세싱이 시작될 수 있도록 모든 레이어의 프로세싱을 동기화하는 것은 어려운 작업이다.

두 번째 구성요소는 커스텀 정밀도이다. 몇 년 전까지는 주요 정밀도로 부동소수점 32가 사용되었다. 그러나 정밀도를 정수 8(Integer 8)까지 줄이는 구글 TPU가 업계를 선도하면서, 최신 기술에서는 INT4, INT2, 바이너리(Binary), 터너리(Ternary)와 같은 더 낮은 정밀도까지 진화하고 있다. 최근 연구에 따르면, 모든 네트워크는 가장 효율적인 혼합 정밀도 조합, 즉 첫 5개 레이어의 경우 8bit, 다음 5개 레이어는 4bit, 마지막 2개 레이어는 1bit와 같이 각기 다른 최상의 조건을 가지고 있는 것으로 확인되고 있다.

마지막 구성요소는 하드웨어 적응성이 필요한 가장 중요한 부분이라고 할 수 있는 커스텀 메모리 계층이다. 강력한 엔진으로 지속적으로 데이터를 처리하는 것이 가장 중요하기 때문에 이러한 레이어 간 메모리 전송 요구를 충족하기 위해서는 내부 메모리에서 외부 DDR/HBM에 이르는 메모리 계층에 대한 커스터마이징이 필요하다.

[그림 1] 모든 AI 네트워크는 커스터마이징이 필요한 3가지 구성요소를 가지고 있다.

AI 상용화 가속

모든 AI 모델은 가장 뛰어난 효율성을 달성하기 위해 커스텀 DSA를 필요로 하고 있으며, 이를 기반으로 한 AI 애플리케이션이 빠르게 증가하고 있다. 분류, 객체감지, 분할, 음성인식, 추천 엔진(Recommendation Engine)은 이미 상용화되고 있는 적용 사례의 일부에 불과하며, 매일같이 새로운 많은 애플리케이션이 등장하고 있다. 또한 이러한 복잡성 증가에는 또 다른 차원의 문제들이 있다. 각 애플리케이션 내에서 정확도를 높이거나 보다 경량의 모델을 만들기 위해 계속해서 더 많은 모델들이 고안되고 있다는 점이다. 분류의 경우, 2012년 AlexNet이 최신 딥러닝을 위한 최초의 혁신이었지만, 이는 피드-포워드(Feed-Forward) 네트워크 토폴로지로 상당히 단순했다. 2013년에 구글이 출시한 Googlenet은 M&R(Map-and-Reduce) 토폴로지와 상당히 유사하다. 그러나 DenseNet 및 MobileNet과 같은 최신 네트워크는 데이터를 앞단의 여러 레이어로 전송해야 하는 뎁스와이즈 콘볼루션(Depthwise Convolution)과 스킵스루(Skip-Through) 등을 가지고 있다. 자일링스 디바이스는 단일 노드/디바이스를 통해 하드웨어에서 소프트웨어에 이르기까지 최신 AI 네트워크에 적응할 수 있는 반면, 다른 공급업체들은 새로운 ASIC이나 CPU, GPU를 재설계해야 한다.

DSA 트렌드

이러한 레벨의 혁신은 지속적으로 기존 하드웨어에 압박을 가하고 있으며, 이를 위해 칩 공급업체들은 신속하게 혁신을 수행해야 한다. 새로운 DSA의 필요성을 가속화하고 있는 몇 가지 최신 경향을 살펴보자. 뎁스와이즈 콘볼루션은 효율성을 높이기 위해 큰 메모리 대역폭과 특화된 내부 메모리 캐싱이 필요한 새로운 레이어이다. 일반적인 AI 칩과 GPU는 고정된 L1/L2/L3 캐시 아키텍처와 제한된 내부 메모리 대역폭으로 인해 효율이 매우 낮다. 연구자들은 끊임없이 새로운 커스텀 레이어를 고안하고 있지만, 오늘날의 칩들은 근본적으로 이를 간단하게 지원할 수 없다. 이로 인해 가속이 되지 않는 호스트 CPU에서 이를 실행해야 하기 때문에 성능 병목현상이 자주 발생한다.

SNN(Sparse Neural Network)은 네트워크 에지를 트리밍하고, 콘볼루션 등에서 세분화된 매트릭스 값을 제거함으로써 네트워크를 최대 99%까지 프루닝(Pruning)할 수 있는 또 다른 유망한 최적화 방법이다. 그러나 하드웨어에서 이를 효율적으로 실행하기 위해서는 특수한 스파스(Sparse) 아키텍처와 이러한 연산을 위한 인코더와 디코더가 필요하지만, 대부분의 칩은 이를 갖추고 있지 않다. 바이너리/터너리는 비트 조작으로 모든 수학 연산을 처리하는 극적인 최적화 방식이다. 대부분의 AI 칩과 GPU는 8bit, 16bit 또는 부동소수점 계산장치만 가지고 있기 때문에 정밀도가 매우 낮아 성능이나 전력 효율성을 얻지 못한다.

2019년 말에 발표된 MLPerf 추론 v0.5는 이러한 모든 문제들을 입증했다. 엔비디아(Nvidia)의 주력 제품인 T4의 결과를 보면, 효율이 13%에 불과했다. 이는 엔비디아가 T4 카드의 피크 성능이 130 TOPS라고 주장하지만, SSD w/Mobile Net-v1와 같은 실제 AI 모델이 활용할 수 있는 하드웨어 성능은 16.9 TOPS에 불과함을 의미한다. 따라서 칩 프로모션을 위해 공급업체가 사용하는 TOPS 수는 의미있는 지표라 할 수 없다.

일부 칩은 AI 추론 가속화에 매우 뛰어나지만, 대부분 전체 애플리케이션의 일부만 가속화할 뿐이다. 예를 들어, 스마트 리테일 적용 사례의 사전 프로세싱에는 비디오의 크기 조정 및 재형성, 포맷, 변환 등을 위해 기존의 컴퓨터 비전 알고리즘에 이어 많은 스트림의 비디오 디코딩이 수행되어야 한다. 또한 사후 프로세싱에는 객체추적 및 데이터베이스 검색 등이 포함된다. 최종 고객은 AI 추론이 얼마나 빨리 실행되는지 보다는 전체 애플리케이션 파이프라인의 비디오 스트리밍 성능이나 실시간 응답 성능의 충족 여부에 더 많은 관심을 갖는다. 대부분의 칩은 개별 작업부하의 가속뿐만 아니라 시스템 레벨의 데이터 플로우를 최적화해야 하는 전체 애플리케이션의 가속화에는 어려움을 겪고 있다.

마지막으로 자동차, 산업자동화, 의료 분야와 같은 실제 생산 영역에서는 수명보장, 강력한 보안 및 인증 기능과 함께 기능 안전성 인증을 갖춘 칩이 매우 중요하다. 새롭게 부상하는 많은 AI 칩과 GPU는 이러한 부분에서 입증된 성능이 아직 부족하다.

이제 자일링스는 어떻게 ‘AI 상용화’ 과제에 대응하고 있는지 알아보자.

자일링스 디바이스는 최신 GPU에 비해 최대 8배의 내부 메모리를 갖추고 있으며, 메모리 계층을 사용자가 완벽하게 커스터마이징 할 수 있다. 이는 뎁스와이즈 콘볼루션과 같은 최신 네트워크에서 ‘유효한’ 높은 TOPS를 달성하는데 있어 매우 중요하다. 사용자가 프로그램이 가능한 FPGA 로직은 가장 효율적인 방법으로 커스텀 레이어를 구현할 수 있도록 함으로써 시스템 병목현상을 제거할 수 있다. SNN의 경우, 자일링스는 오랫동안 통신 분야의 여러 스파스 매트릭스 기반 신호처리 애플리케이션을 구축해 왔다. 사용자는 FPGA 패브릭에 특화된 인코더, 디코더 및 스파스 매트릭스 엔진을 설계할 수 있다. 또한 바이너리/터너리의 경우, 자일링스 FPGA는 LUT(Look-Up-Table)를 사용하여 비트 레벨 조작을 구현함으로써 정수 8 대신 바이너리를 사용하여 1 PetaOps(1000 TOPS)에 근접하는 성능을 달성할 수 있다. 또한 모든 적응형 하드웨어 기능을 통해 모든 최신 AI 추론 작업부하에 대한 100%에 이르는 하드웨어 피크 성능에 근접할 수 있다.

전체 애플리케이션 가속화 측면에서, 자일링스는 여러 산업 분야에서 이미 센서융합 및 기존의 컴퓨터 비전과 DSP 알고리즘, 경로 플래닝 및 모터제어와 같은 비-딥러닝 작업부하의 가속과 관련한 생산 단계의 경험을 갖추고 있다. 또한 자일링스는 일반적인 작업부하에서 상당한 속도 향상을 입증한 바이티스(VitisTM) 브랜드 기반의 900개 이상의 하드웨어 가속 라이브러리를 보유하고 있다.

디바이스 품질은 우주, 자동차, 산업자동화 및 의료 수술용 보조 로봇과 같은 안전이 가장 중요한 환경에 디바이스가 구현되면서 자일링스의 강점 중 하나로 잘 알려져 있다. 자동차 분야의 경우, 자일링스는 12년 이상 자동차 산업에 총 1억 6,100만 개의 디바이스를 선적했으며, 거의 모든 OEM과 선도업체들에게 기능안전 및 오랜 수명, 보안 기능을 제공함으로써 최고의 신뢰성을 인정받고 있다.

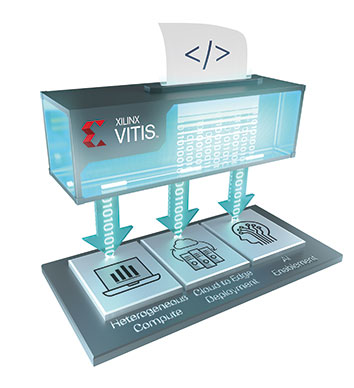

또한 자일링스는 소프트웨어 개발 전문가들도 자일링스 디바이스에 액세스할 수 있는 솔루션을 개발했다. 자일링스는 개발자들이 이기종 플랫폼에서 애플리케이션을 가속화하고, 클라우드 컴퓨팅에서 임베디드 엔드-포인트에 이르는 애플리케이션을 타깃할 수 있도록 AI와 소프트웨어 개발을 단일화한 새로운 통합 소프트웨어 플랫폼인 바이티스(Vitis™)를 개발했다. 이는 표준 환경에 연결이 가능하고, 오픈소스 기술을 사용할 수 있으며, 무료로 제공된다. 바이티스 내에서 제공되는 바이티스 AI(Vitis AI)는 트레이닝 모델을 최적화하고, 양자화 및 컴파일이 가능한 툴을 제공하며, 엣지에서 클라우드까지 최상의 추론 성능과 효율을 구현할 수 있는 특화된 API를 지원한다. 이 AI 스택은 직접 프레임워크에서 프로그램할 수 있으며, AI 모델 최적화(프루닝) 및 양자화 등이 포함된 툴킷이 함께 제공된다. 바이티스 AI는 표준 프레임워크에서 직접 추론을 처리할 수 있어 하드웨어에 대한 지식이 없어도 모든 자일링스 디바이스 상에서 매우 뛰어난 가속화를 구현할 수 있다.

[그림 2] 통합 소프트웨어 플랫폼, 바이티스(Vitis)

알베오 U55C의 출시로 HPC 업계에 많은 가치 제공할 것

조회수 814회 / Nathan Chang

엣지 센서에서 CPU 가속기까지 ‘버설 AI 엣지 시리즈’

조회수 1020회 / Rehan Tahir

적응형 컴퓨팅, 포스트-무어의 법칙 시대에서 성장을 주도하다

조회수 1364회 / Victor Peng

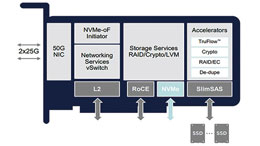

데이터센터 혁신을 위한 장벽 없는 FPGA 솔루션

조회수 1005회 / Kartik Srinivasan 외 2인

자동차 시장의 혁신을 선도하는 자일링스의 DNA

조회수 741회 / Yousef Khalilollahi

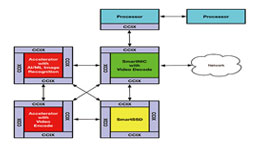

CXL, CCIX 기반 PCIe 5와 SmartNIC은 어떻게 가속 솔루션을 혁신하고 있...

조회수 6818회 / Scott Schweitzer

대규모 5G 무선 구축을 위한 혁신적인 징크 RFSoC DFE

조회수 1499회 / Gilles Garcia

SmartNIC 아키텍처: 가속기로의 이행, 그리고 FPGA가 우위를 점하는 이유

조회수 4481회 / Scott Schweitzer

SmartNIC이 일반 NIC보다 뛰어난 이유는?

조회수 1872회 / Scott Schweitzer

PDF 다운로드

회원 정보 수정