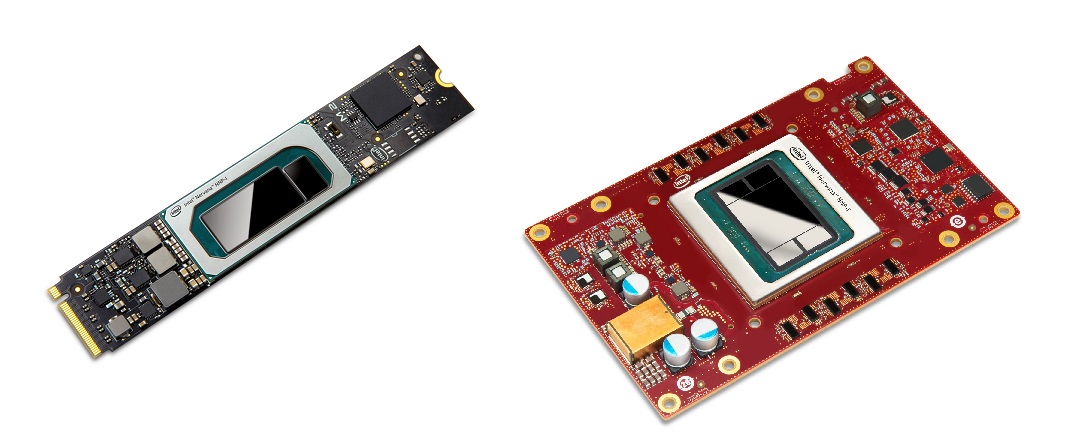

인텔, 너바나(Nervana) 뉴럴 네트워크 프로세서(NNP)는 트레이닝(NNP-T1000)과 추론(NNP-I1000)을 위한 제품이다

![[사진] 나빈 라오(Naveen Rao) 인텔 부사장 겸 인공지능 제품 그룹 총괄 (3) [사진] 나빈 라오(Naveen Rao) 인텔 부사장 겸 인공지능 제품 그룹 총괄 (3).JPG](https://www.seminet.co.kr/webnote/upload/_quick/2019/11/13/8ad02b3a33de658_15736056337915503062.jpg)

<나빈 라오(Naveen Rao) 인텔 부사장 겸 인공지능 제품 그룹 총괄>

인텔은 미국 샌프란시스코에서 열린 AI 서밋 2019(AI Summit 2019)에서 클라우드에서 엣지까지 AI 시스템 개발 및 구현을 가속화하도록 설계된 새로운 제품 업데이트를 공개하고 차세대 AI 혁신을 선보였다. 이날 시연한 인텔® 너바나(Nervana)™ 뉴럴 네트워크 프로세서(NNP)는 트레이닝(NNP-T1000)과 추론(NNP-I1000)을 위한 제품으로, 클라우드 및 데이터센터 고객을 위한 놀라운 확장성과 효율성을 지원하는 인텔 첫 AI 전용 주문형 반도체(ASIC) 제품이다. 인텔은 또한 엣지 미디어, 컴퓨터 비전 및 추론 응용 프로그램을 위한 차세대 인텔® 모비디우스™ 미리어드™(Movidius™ Myriad™) 비전 프로세싱 유닛(VPU)을 공개했다.

나빈 라오(Naveen Rao) 인텔 부사장 겸 인공지능 제품 그룹 총괄은 “AI의 다음 단계에서 우리는 컴퓨팅 하드웨어 및 메모리의 한계에 도달하고 있다”며, “AI의 놀라운 발전을 지속하려면 인텔 너바나 NNP 및 모비디우스 미리어드 VPU와 같은 전용 하드웨어가 필요하다. 보다 앞선 시스템 수준의 AI를 사용하면 데이터를 정보로, 정보를 지식으로 변환하는데 큰 도움이 될 것이다”라고 밝혔다.

해당 제품들은 2019년에 35억 달러 이상의 매출을 올릴 것으로 예상되는 인텔의 AI 솔루션 포트폴리오를 더욱 강화한다. 업계에서 가장 광범위하고 깊이 있는 인텔의 AI 포트폴리오는 고객이 대규모 클라우드에서 소규모 엣지 디바이스까지 모든 규모에서 AI 모델을 개발하고 구현할 수 있도록 지원한다.

현재 생산되어 고객에게 제공중인 새로운 인텔 너바나 NNP는 시스템 수준 AI 접근 방식의 일부로, 최대한의 활용을 위해 개방형 구성 요소 및 딥 러닝 프레임 워크 통합으로 개발된 완전한 소프트웨어 스택을 제공한다.

인텔 너바나 NNP-T는 컴퓨팅, 통신, 메모리 간의 최적의 균형을 유지해 소규모 클러스터에서 최대 포드 슈퍼컴퓨터에 이르기까지 선형에 가까운, 에너지 효율적인 확장성을 제공한다. 인텔 너바나 NNP-I는 전력과 예산을 효율적으로 사용하고 유연한 폼팩터를 통해 강력한 다중 모드 추론을 실제 구현하는데 이상적이다. 두 제품 모두 바이두 및 페이스북과 같은 최첨단 AI 고객의 AI 처리 요구에 맞게 개발되었다.

<인텔 너바나 NNP(뉴럴 네트워크 프로세서)-I와 T>

미샤 스메랸스키(Misha Smelyanskiy) 페이스북 AI 시스템 공동 설계 부문 디렉터는 “인텔과 협력해 인텔 NNP-I를 기반으로 더욱 빠르고 효율적인 추론 성능을 구현하고, NNP-I에 최첨단 딥 러닝 컴파일러 Glow를 위한 지원을 확장할 수 있어 매우 기대된다”고 말했다.

이와 함께2020년 상반기에 출시될 차세대 인텔 모비디우스 VPU는 매우 특별하고 고효율적인 아키텍처 기술을 통합해, 경쟁사 프로세서보다 최고 6배 우수한 전력 효율성과 이전 세대보다 10배 이상 높은 추론 성능을 제공할 것으로 예상된다. 인텔은 또한 인텔® 오픈 비노™(OpenVINO™) 툴킷 디스트리뷰선과 함께 엣지용 인텔® 데브클라우드(DevCloud)를 발표해 개발자들이 하드웨어를 구매하기 전에 광범위한 인텔 프로세서 기반에서 AI 솔루션을 시도해보고, 테스트하고 프로토타입화할 수 있도록 지원해 개발자들의 어려움을 해결한다고 밝혔다.

딥 러닝 추론 및 컨텍스트를 발전시키기 위해서는 엄청나게 복잡한 데이터, 모델 및 기술이 필요하며 아키텍처에 대해 다르게 생각할 필요가 있다.

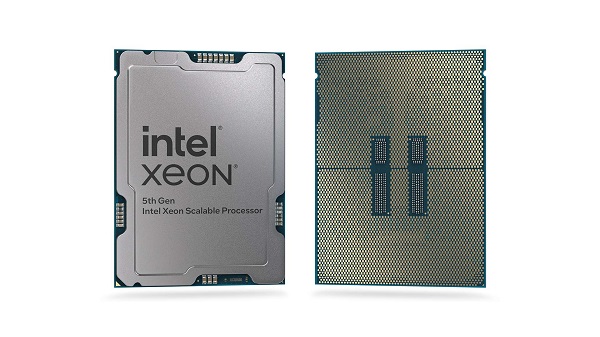

전세계 대부분이 인텔® 제온® 스케일러블 프로세서에서 AI의 일부를 구동함에 따라 인텔은 지속적으로 VNNI(Vector Neural Network Instruction)를 포함한 인텔 딥 러닝 부스트와 같은 기능들로 해당 플랫폼을 개선하고 있으며, 이는 개선된 AI 추론 성능을 데이터 센터와 엣지에 제공한다. 이 기술은 향후 몇 년간 강력한 AI 기반으로 사용될 것이지만, 고객은 가장 향상된 딥 러닝 트레이닝을 위해 3.5 개월마다 성능을 두 배 이상 높일 것을 요구한다. 이러한 혁신은 인텔의 AI솔루션 포트폴리오 상에서만 가능하다. 인텔은 컴퓨팅, 메모리, 스토리지, 상호 연결, 패키징 및 소프트웨어 전체에서 효율성, 프로그래밍 가능성을 최대화하고 수 천 개의 노드에 딥 러닝을 분산시켜 지식 혁명을 확장할 수 있는 중요한 능력을 보장한다.

인텔 파운드리, 고개구율 극자외선(High-NA EUV) 도입으로 칩 제조 분야...

조회수 86회 / Intel

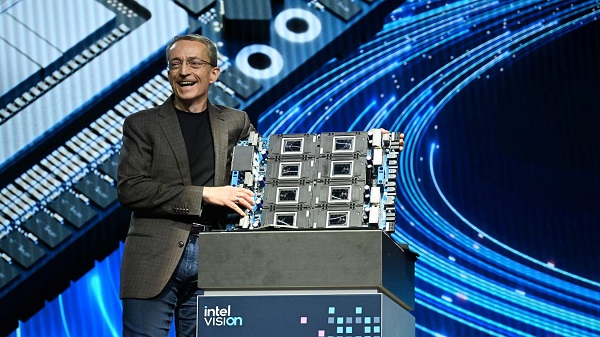

인텔, 기업용 생성형 AI 시장 독점 구조 타개할 선택지로 가우디 3 발표

조회수 85회 / Intel

인텔 가우디 2, 생성형 AI 성능에서 벤치마크 결과 제공 가능한 NV H100...

조회수 115회 / Intel

인텔, AI PC 소프트웨어 개발자 및 하드웨어 벤더를 위한 신규 프로그램...

조회수 75회 / Intel

인텔, 세계에서 가장 빠른 데스크톱 프로세서 14세대 인텔 코어 i9-1490...

조회수 175회 / intel

인텔, 알테라(Altera)를 신생 FPGA 기업으로 독립

조회수 141회 / 인텔

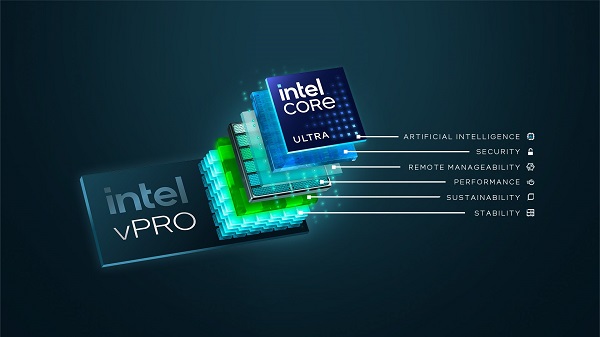

인텔, 새로운 vPro 플랫폼을 통해 엔터프라이즈용 AI PC에 인텔 코어 Ul...

조회수 141회 / Intel

Intel-오하이오 슈퍼컴퓨터 센터, 새로운 HPC 클러스터로 AI 처리 능력 ...

조회수 181회 / Intel

인텔, 2030년까지 파운드리 2위 목표

조회수 188회 / 인텔

PDF 다운로드

회원 정보 수정